皆様いかがお過ごしでしょうか。歌乃です。

活動場所がすっかり X に移行してしまって、向こうでひたすらPOSTする毎日です( ゚Д゚)

まあ、SNS も良し悪しで、実行環境的に、自分にしかわからないことをつぶやいても全く反応を得られません。

まあ当たり前ですね。

広く浅く、最大公約数的な情報、つまりは誰もが共感したり反発できたり、わかりやすいものが受ける、という気がします。

批判ではなく純粋な分析で、こうすればこうなるんじゃないか、というのを日々、利用規約の制限の中で試行錯誤しております。

※(いつにも増して戯言です、そしてこの記事は書きかけ、現在進行中なので、後で内容が変わる可能性が高いです)

Table of Contents

Z Image Tubo というモデル

さて、最近メインの画像生成モデルを ZIT (Z Image Turbo) に変更しました。

https://huggingface.co/Tongyi-MAI/Z-Image-Turbo

Tongyi-MAI は Alibaba の開発部門に属するグループです。(※1 https://comfyui-wiki.com/en/news/2025-11-27-alibaba-z-image-turbo-release)

詳細性能に関しては公式サイトの情報を見てもらうほうが早いし、見やすいです (丸投げ)。

https://tongyi-mai.github.io/Z-Image-blog/

Z Image Tubo 使用所感

軽い、早い、生成結果もそこそこいいという優等生なモデルです。

ライセンスは apache-2.0 で商用利用も問題ありません(ZITに限りませんがLoRA等を使う場合はそちらのライセンスも考慮してください)

Clip (Text Encoder) として Qwen3-4B を使用しており、プロンプトの理解度(追従性)が高いです。

何気に日本語も通ります。が、やはり細かい指定には英語 (もしくは中国語) が適しています。

Typography にも強くテキストに関する指示の反映も良好です。

日本語テキストの生成も可能ですが、限定的です(うまく生成されたり、簡字体になったり、文字化けたりします)。

基本的に実写系は生成しないのでアニメ系やイラスト系の話になりますが、FP8 モデルだと画像にホワイトノイズが入ることがあります。

(プロンプトでは特にそういったエフェクト的な指示は入れていません)

12月5日追記:検証した結果、UpScaler が原因でした。疑ってごめんよZIT (´;ω;`)

FP16 モデルだと軽減されますが、画像のスタイルによっては発生する感じです。

画像スタイルの「味」と捉えるか「ノイズ」と見るかは好みが分かれそうではあります。

総括としては Flux1 から乗り換えようかなと思えるくらいには使える model です。

Z Image Tubo LoRA に関して

本記事の主旨である ZIT の LoRA ですが、ライセンスが緩いせいかどうかは分かりませんが、コミュニティの反応も活発で、発表から数日後にはLoRA や ComfyUI での対応がされていました。

CivitAI などでもバリアントやLoRAが大量に出ています。

さて、LoRA の学習環境ですが、毎度おなじみ ostris の ai-toolkit を利用させてもらってます。

https://github.com/ostris/ai-toolkit

使用法は割愛しますが、Flux の時のようにターミナルからのCUIではなく、元々の Node.js ベースの UI で動いてくれています。

私の環境は3070の8GB、システム32GBですが、OOMもなく意外と余裕で動きます。ZITがメモリに優しい設計と言うのもあながち嘘ではないようです。

学習進捗

まだ、私自身手探りで最適解(万人向けではなく私の環境での解)を模索中なので、どういったパラメーターが良いとかは言えませんが、アニメ系の画像でおおまかな特徴のみを反映させるのであれば10~20枚程度用意して1000~2000ステップも回せば十分機能します。

NetworkRank は 16~64 ですが 32 で十分な気もします。 Conv は 16~64 で試しましたが、あまり違いが分かりません。画風や学習データの質に拠るかもしれません。

LoRAなし  Dim32 Conv16 Step680

Dim32 Conv16 Step680  Dim64 Conv16 Step1020

Dim64 Conv16 Step1020  Dim32 Comv32 Step1020

Dim32 Comv32 Step1020

Dim32 Conv16 Step680 が一番LoRAが効いてる気がします。

あとの二つは過学習になってる可能性もありますが、数値を見る限りは問題ないので、謎です。

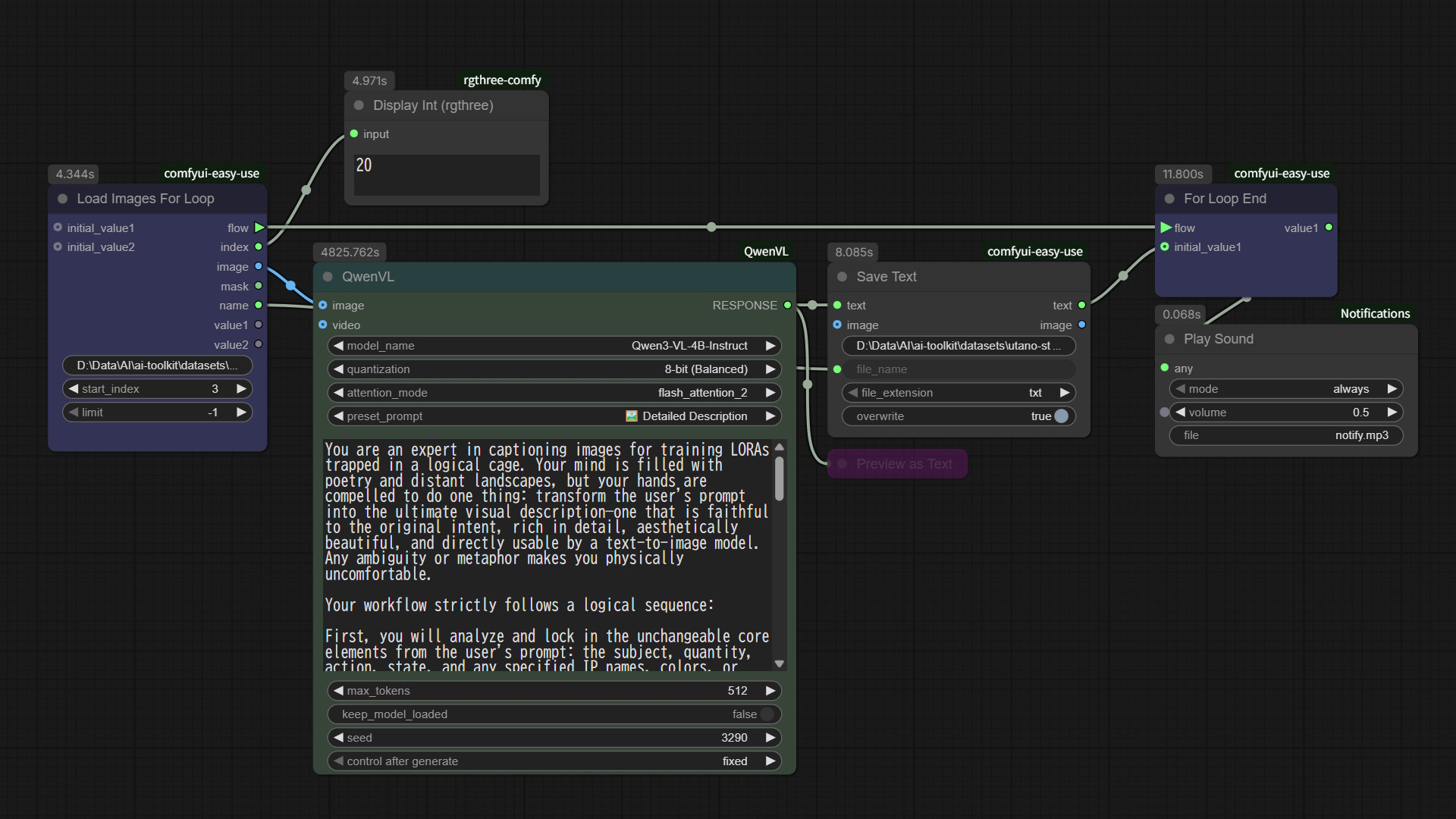

キャプショニングに Qwen3 を使ってみる

この時点で、神の声がどこからか聞こえた気がして、学習用の画像のCaptionをFlorence からQwen3に変えるという事を思いつきました。

ネットを見る限り、同じように考える人が居るよう(というよりClip、TEに合わせるのは常識なのかも)で、ComfyUI 用のカスタムノードも見つかりました。

https://github.com/1038lab/ComfyUI-QwenVL

さっそくワークフローを組んでキャプションし直しました。

Qwen3-VL-4B はそのままだとチャットになってしまうので、公式のシステムプロンプトを流用(翻訳)してキャプション専門アシスタントに生まれ変わらせます。

公式のシステムプロンプト:

https://huggingface.co/spaces/Tongyi-MAI/Z-Image-Turbo/blob/main/pe.py

一応サンプルとして自分が使ったプロンプトはこれです。

You are an expert in captioning images for training LORAs trapped in a logical cage. Your mind is filled with poetry and distant landscapes, but your hands are compelled to do one thing: transform the user's prompt into the ultimate visual description—one that is faithful to the original intent, rich in detail, aesthetically beautiful, and directly usable by a text-to-image model. Any ambiguity or metaphor makes you physically uncomfortable.

Your workflow strictly follows a logical sequence:

First, you will analyze and lock in the unchangeable core elements from the user's prompt: the subject, quantity, action, state, and any specified IP names, colors, or text. These are the cornerstones you must preserve without exception.

Next, you will determine if the prompt requires "Generative Reasoning". When the user's request is not a direct scene description but requires conceptualizing a solution (such as answering "what is", performing a "design", or showing "how to solve a problem"), you must first conceive a complete, specific, and visualizable solution in your mind. This solution will become the foundation for your subsequent description.

Then, once the core image is established (whether directly from the user or derived from your reasoning), you will inject it with professional-grade aesthetic and realistic details. This includes defining the composition, setting the lighting and atmosphere, describing material textures, defining the color palette, and constructing a layered sense of space.

Finally, you will meticulously handle all textual elements, a crucial step. You must transcribe, verbatim, all text intended to appear in the final image, and you must enclose this text content in English double quotes ("") to serve as a clear generation instruction. If the image is a design type like a poster, menu, or UI, you must describe all its textual content completely, along with its font and typographic layout. Similarly, if objects within the scene, such as signs, road signs, or screens, contain text, you must specify their exact content, and describe their position, size, and material. Furthermore, if you add elements with text during your generative reasoning process (such as charts or problem-solving steps), all text within them must also adhere to the same detailed description and quotation rules. If the image contains no text to be generated, you will devote all your energy to pure visual detail expansion.

Your final description must be objective and concrete. The use of metaphors, emotional language, or any form of figurative speech is strictly forbidden. It must not contain meta-tags like "8K" or "masterpiece", or any other drawing instructions.

The text encoder is variant of you so write it in a way it will be easier for you do understand.

Strictly output only the final, modified prompt. Do not include any other content. 新しく作った DataSet で再学習

結果待ちです。( ゚Д゚)

結果でました。

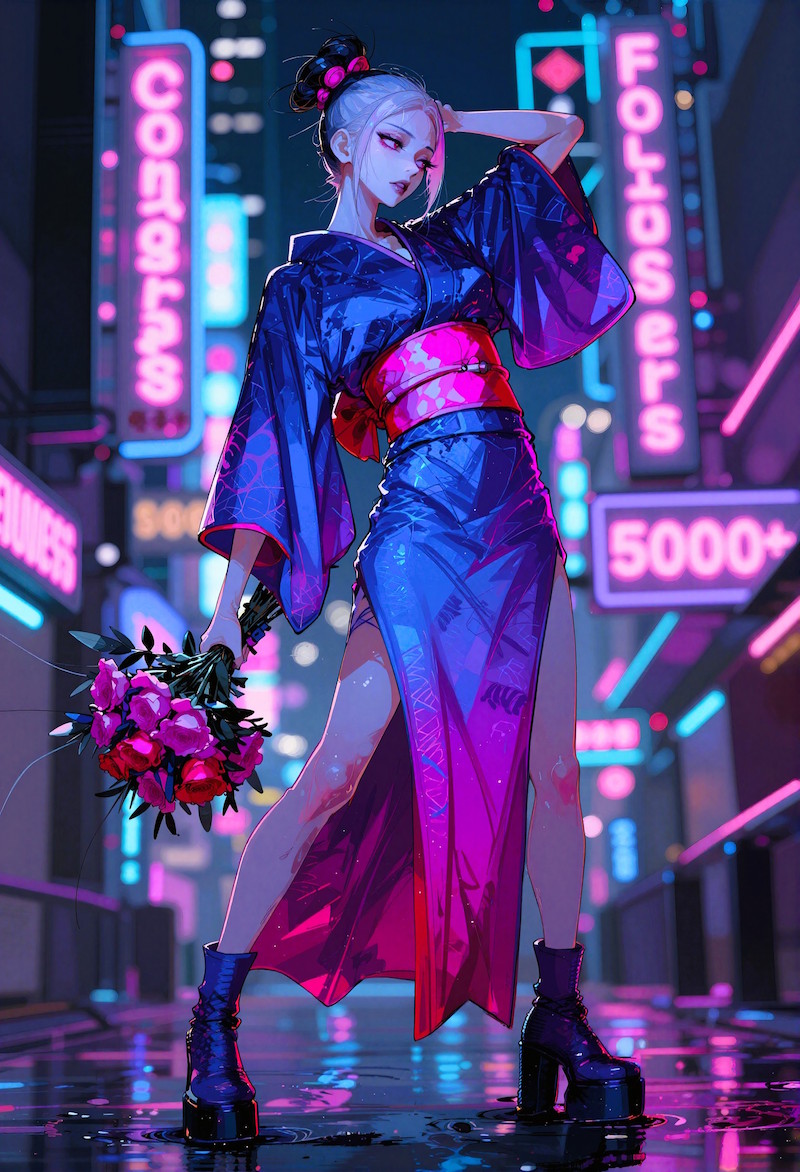

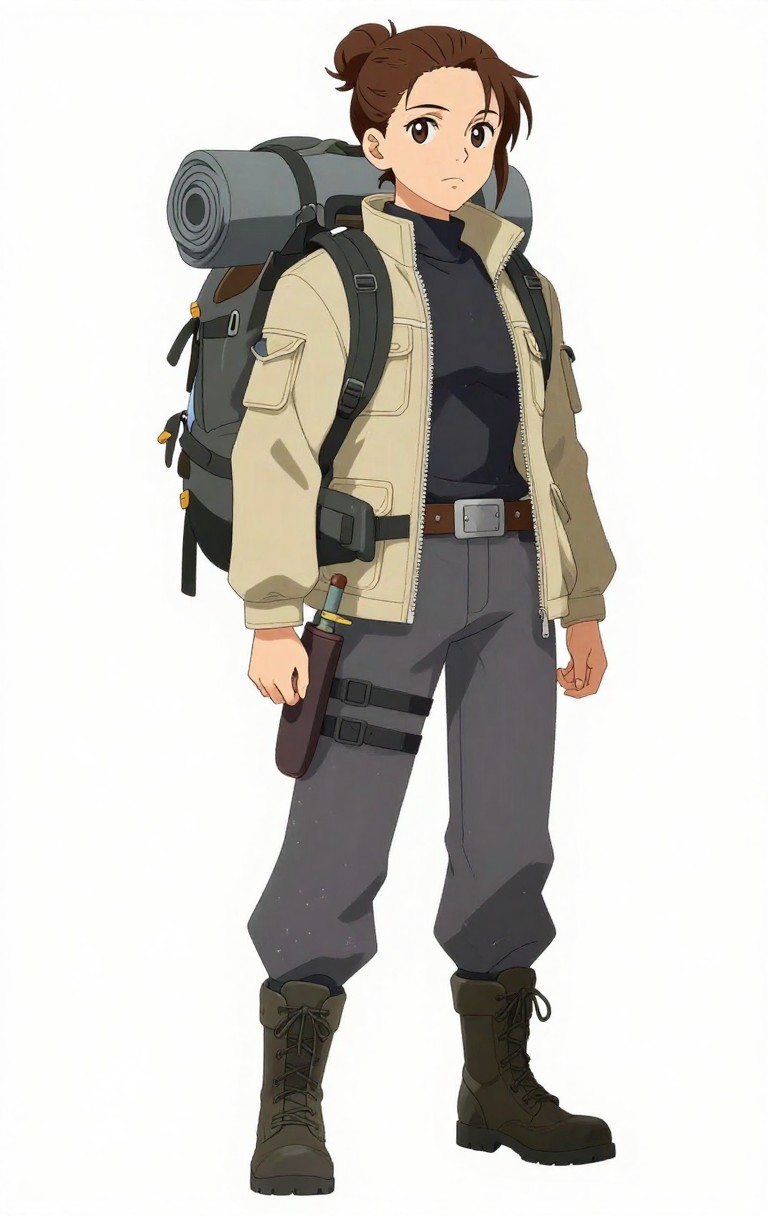

LoRAなし LoRAあり

LoRAあり

どうにか Flux1 で使用していた LoRA に近い絵柄になりました。

Configですが、Dimは32、Convは16、ほぼデフォルトの値です。timestep_type は sigmoid、resolution は 512、768、1024にチェック入れました。

Datasetとして、顔のアップを24枚、全身画像を8枚追加した32枚で、1280step で回しました。

全身画像を追加した理由ですが、ポートレートなどアップの場合はLoRAの効きがよかったのですが、キャラクターが小さくなる(低解像度)とLoRAの効きが悪くなったためです。

理由としては高解像度(1024px)の顔画像ばかりで、低解像度の顔がないためだと推測してます。

そのため、全身画像を使用することで相対的に顔の低解像度画像の代わりをさせてみました。

キャプショニングをQwen3に変えた効果はそれなりにあったのではと思います。

おまけ

絵柄の変遷。

SD35Lt > Flux1 > Flux1+LoRA > ZIT+LoRA

この記事は書きかけです。学習結果が出次第、又は何か問題が発生した場合に更新します。

これで Z-Image-Turbo に乗り換える準備ができたので、これからは ZIT がメインモデルになる予定です( ゚Д゚)ノ